En busca de nuevos foros para la regulación de los algoritmos en el ámbito militar.

El contexto tecnológico

En 1980, el académico David Collingridge propuso un modelo teórico para abordar el dilema que surge al regular tecnologías emergentes. Este problema, referido muchas veces como dilema de Collingridge, describe cómo los reguladores políticos pueden enfrentarse a la difícil decisión de si regular o no una nueva tecnología.

Las necesidades de regulación pueden cambiar con el tiempo. Las redes sociales y los patinetes eléctricos son ejemplos de cosas que antes no se consideraban problemáticas, pero ahora requieren regulación. Los reguladores deben detectar estas necesidades emergentes y actuar en el momento oportuno, ya sea a través de un proceso regulatorio o trabajando con el sector privado, aunque esto puede presentar desafíos debido a los intereses del sector privado.

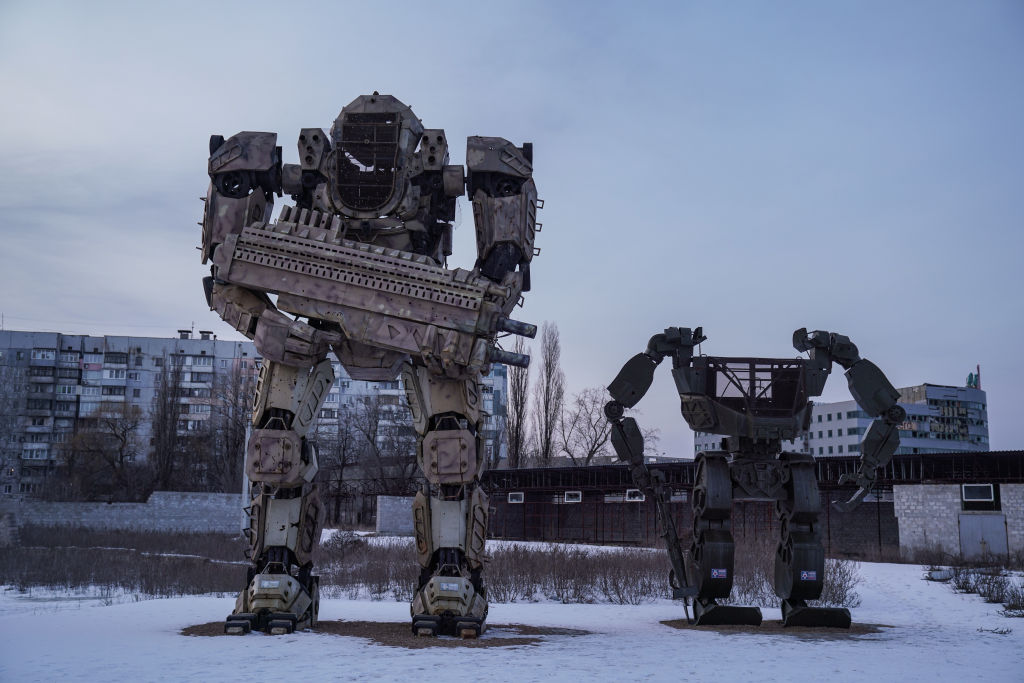

Al igual que con las redes sociales y los patinetes eléctricos, la Inteligencia Artificial (IA) en el ámbito militar es un ejemplo de una tecnología emergente que puede requerir regulación. A medida que la IA se utiliza cada vez más en aplicaciones militares, como el análisis de imágenes satelitales, la vigilancia autónoma de áreas fronterizas o el desplazamiento autónomo es importante que los reguladores detecten y aborden cualquier necesidad emergente de regulación en este ámbito. Esto es así, porque la autonomía puede usarse para encontrar y atacar objetivos en los conflictos armados, lo que plantea dilemas éticos y jurídicos. En teoría, aún necesitan la orden de un operador militar, pero según los propios fabricantes, esto podría cambiar con un ajuste del software. ¿Hemos pasado ya del momento oportuno para regular este asunto?

El esfuerzo internacional por regular

El debate sobre el potencial letal de la Inteligencia Artificial en los sistemas de armas comenzó hace más de 15 años en la academia. En 2007, Robert Sparrow usó por primera vez el término “Killer Robots”. La organización Human Rights Watch y la plataforma Stop Killer Robots, fundada en 2012 por HRW y otras ONG, adoptaron este término por su gran impacto gráfico.

La publicación del informe del Relator especial para ejecuciones extrajudiciales, sumarias o arbitrarias de Naciones Unidas, Christof Heyns, de 2013, dio finalmente pie a la vía institucional. La Asamblea General de la ONU decidió que la Convención sobre ciertas Armas Convencionales (CAC) sería el foro más adecuado para regular o prohibir ciertas categorías de armas por sus efectos indiscriminados. Tras unos primeros encuentros informales entre 2014 y 2016, se decidió crear un Grupo de Expertos Gubernamentales (GEG) con el objetivo de preparar propuestas para la próxima conferencia de revisión en 2021. Entre 2017 y 2021, el grupo se reunió tres veces al año con la participación de delegaciones oficiales y actores de la sociedad civil, excepto en 2020, donde las reuniones se llevaron a cabo de forma telemática debido a la pandemia.

Hasta la fecha, los resultados del Grupo de Expertos Gubernamentales (GEG) sobre sistemas de armas autónomos letales han sido modestos. En las sesiones de 2018 y 2019 se acordaron 11 principios guía que hacen hincapié en la responsabilidad humana sobre los sistemas de armas y la necesidad de cumplir con el Derecho Internacional Humanitario (DIH), entre otros. Estas declaraciones son bien intencionadas, pero no tienen ningún compromiso legal.

Desde el comienzo ha surgido una división entre los países que desarrollan tecnología militar de vanguardia y una creciente mayoría de Estados que abogan por un tratado vinculante. Los representantes de la sociedad civil han observado impotentes como sus propuestas han sido rechazadas una tras otra por Estados Unidos, Rusia, India e Israel. La necesidad de consenso en la toma de decisiones impide que la mayoría de los países dispuestos a negociar un tratado vinculante prevalezca.

Esta situación se ha agravado en el contexto de la guerra en Ucrania. No solo se están utilizando cada vez más drones suicidas en ambos lados del conflicto, sino que Rusia se ha enrocado en el GEG y veta cualquier intento de regulación sustancial. En la sesión de marzo de 2023 y de nuevo en la última sesión que concluyó el 19 de mayo, Rusia vetó la presencia de los actores civiles en las reuniones. Las ONG e incluso el Comité Internacional de la Cruz Roja tuvieron que abandonar la sala. Como resultado, los encuentros de los actores civiles pasaron al formato informal, mientras las delegaciones de los países se reunieron a puerta cerrada.

Nuevos foros

Considerando la situación del bloqueo de propuestas sustanciales casi constante, han aumentado las voces que exigen que se cree un nuevo foro específico para negociar un tratado vinculante para las armas autónomas. Human Rights Watch publicó en noviembre de 2022 un documento en el que la autora principal – Bonnie Docherty, experta en armas y protección de civiles durante conflictos armados, e investigadora senior en Human Rights Watch – señala tres procesos de control de armas en el pasado que llevaron a tratados vinculantes entre países voluntarios. Las armas que se prohibieron en dichos tratados son las minas antipersonales, en vigor desde 1999, las municiones en racimo, en vigor desde 2010, y el de las armas nucleares que entró en vigor el 22 de enero de 2021. En los tres casos, los países se comprometieron al principio de los encuentros a negociar con el objetivo de elaborar un tratado vinculante. Otra clave fue el voto mayoritario cualificado, mecanismo que impide el abuso del veto por actores individuales.

El documento de HRW ha sido acogido ampliamente por la sociedad civil y muchas delegaciones estatales, pero los acontecimientos han ido por otros derroteros. En respuesta a la guerra en Ucrania y la actitud rusa en el GEG, Países Bajos y Corea del Sur organizaron conjuntamente una cumbre en La Haya, sin invitar a Rusia. Los días 15 y 16 de febrero, más de 2.000 representantes de 80 países, empresas de tecnología militar, academia y ONG se reunieron en la Cumbre REAIM 2023. La revista Ethics and Information Technology Journal editó un número especial titulado “Responsible AI in Military Applications”, que dio nombre a dicha cumbre. También participaron las organizaciones civiles habituales, además representantes de compañías tecnológicas como Boston Dynamics, empresa estadounidense que desarrolla robots para usos de seguridad.

A pesar del formato pretencioso del evento, el resultado fue solamente un documento llamado “Call to Action” firmado por 57 Estados, sin la participación de India, Brasil, Suráfrica y varios otros. El documento hace un llamamiento a la acción para un uso responsable de la IA en el ámbito militar. Reconoce que el desarrollo de ésta tiene principalmente lugar en el ámbito civil y que su introducción en el militar es un desafío para múltiples partes interesadas. El informe invita a los Estados a aumentar su comprensión de la IA militar a través de la investigación, la capacitación y las actividades de desarrollo de capacidades. También los alienta a trabajar juntos e involucrar al sector privado, la sociedad civil y la academia para promover el uso responsable de la IA en el ámbito militar. Además, invita a los países a desarrollar marcos, estrategias y principios nacionales sobre el uso responsable de la IA en el ámbito militar.

Corea del Sur, otra de las potencias líderes en tecnología militar, se compromete a organizar una segunda cumbre para el otoño de 2023.

Sin embargo, el contenido insustancial del documento final ocasionó la decepción entre varios participantes, especialmente los actores civiles y varios países defensores de un instrumento legal vinculante.

Uno de estos países, Costa Rica, organizó los días 23 y 24 de febrero una cumbre en su capital San José, la Conferencia de América Latina y el Caribe sobre el impacto social y humanitario de las armas autónomas, donde se reunieron representantes de una treintena de países latinoamericanos y del Caribe, así como los actores habituales como las ONG afiliadas a Stop Killer Robots, el CICR y varios expertos en investigación de IA, entre ellos los activistas Stuart Russell y Toby Walsh.

Como indica el nombre de este evento, los organizadores se preocuparon más de los impactos sociales y la deshumanización digital, conceptos que señalan la reducción de las personas a una matriz de píxeles, sobre la que un arma autónoma decidiría atacar si la imagen corresponde a un patrón de rasgos predefinido. Es un aspecto clave porque muchos de los dispositivos para la detección de objetivos – en este caso personas – se utilizan tanto en conflictos armados como en el ámbito de seguridad interior.

Los treinta países latinoamericanos y del Caribe, entre los cuales figuran Argentina, Brasil, Chile, Perú y el país anfitrión, firmaron el comunicado de Belén. Este documento reitera la necesidad “de promover la negociación urgente de un instrumento jurídicamente vinculante internacional, con prohibiciones y regulaciones con respecto a la autonomía en los sistemas de armas”. Asimismo, destaca la importancia del control humano significativo sobre el uso de la fuerza para “prevenir una mayor deshumanización de la guerra y garantizar la responsabilidad individual y estatal”.

Ray Acheson, activista y directora de Reaching Critical Will, el programa de desarme de la Liga Internacional de Mujeres por la Paz y la Libertad (WILPF, por sus siglas en inglés) escribió en una editorial tras el fracaso de la última sesión del 19 de mayo de 2023 que sería hora de abandonar el “chatbox” de la CAC. Teniendo en cuenta que las discusiones dentro de este foro llevan nueve años sin haber llegado a ningún compromiso legal, está claro que los debates tienen que ir por otro cauce: un foro creado ad hoc de países voluntarios que están dispuestos a comprometerse en un tratado que regula el empleo de la Inteligencia Artificial en las aplicaciones militares, así como la prohibición de las funciones críticas de seleccionar y atacar un objetivo sin intervención humana.

La brecha entre los países líderes en tecnología militar y aquellos que no tienen este potencial se está profundizando y las ONG se están uniendo a estos últimos. Hay razones para estar preocupados, ya que la evolución tecnológica no se detiene. Pocas semanas antes de la segunda sesión del GEG en mayo, Palantir – una empresa estadounidense especializada en el análisis de big data – publicó un vídeo con su nuevo producto Artificial Intelligence Platform (AIP), un software basado en Inteligencia Artificial generativa. En el vídeo promocional, los operadores militares utilizan una interfaz similar a ChatGPT para diferentes actividades como solicitar supervisión por drones o generar diferentes planes de ataque. El operador depende de las informaciones que le aporta la máquina, y toma su correspondiente decisión. La interfaz entre el humano y la máquina queda reducida a una especie de asistente virtual para las operaciones militares.

Collingridge describió la tardanza en la regulación de nuevas tecnologías como un problema de percepción. Cuando un cambio está en su etapa incipiente, puede pasar desapercibido o no se ve la necesidad de regular la tecnología. Sin embargo, hoy la situación es diferente. Si bien hace 15 años la autonomía en los sistemas de armas militares era un fenómeno incipiente, hoy estamos observando que ya está disponible en muchos sistemas. Las declaraciones políticas bienintencionadas no son suficientes para enfrentar la amenaza que representa la Inteligencia Artificial en las armas no reguladas.