Los vídeos ultrafalsos no van a desaparecer. Hay que aprender a convivir con ellos y conocerlos para mitigar los daños.

En mayo de 2017, unos piratas informáticos vinculados a los Emiratos Árabes Unidos entraron en los ordenadores del gobierno de Qatar y publicaron unas supuestas declaraciones del emir, el jeque Tamim bin Hamad al Thani, en las que elogiaban a Hamás y calificaba a Irán de “potencia islámica”. Arabia Saudí aprovechó esas presuntas afirmaciones del jefe de gobierno catarí para acusarlo de apoyar el terrorismo, y convenció a otros Estados árabes, africanos y del Golfo para que cortaran sus relaciones diplomáticas y de transporte con Qatar. La alianza encabezada por los saudíes exigió, entre otras cosas, que el Gobierno de Qatar cerrara la cadena de noticias Al Jazeera. Se habló de una actuación militar. El presidente Trump, en su primer viaje al extranjero como tal, se sumó al bloqueo. Fueron necesarias las intervenciones del secretario de Defensa estadounidense James Mattis (preocupado por las repercusiones para la base norteamericana en Qatar) y el secretario de Estado Rex Tillerson para que los saudíes dieran un paso atrás en su intención de tomar medidas militares. No obstante, el amplio bloqueo sigue vigente. Qatar demostró posteriormente que el mensaje ofensivo era falso y acusó al Gobierno de los Emiratos Árabes Unidos (EAU) de patrocinar a los piratas informáticos.

Su argumento era, en esencia, que los EAU o sus agentes habían pirateado de forma deliberada las páginas web del gobierno catarí con el fin de crear una provocación que sirviera de excusa para la acción militar. De ser cierto —Qatar todavía no ha logrado demostrar de forma categórica la acusación—, esto dejaría al descubierto el peligro de las campañas de desinformación cibernética en las relaciones internacionales. Una campaña virtual podría haber estado cerca de causar un conflicto militar en un espacio físico: qué fácil es que el ciberespacio infecte el espacio material. Ahora imaginemos si, en lugar de limitarse a insertar la provocadora declaración en las páginas gubernamentales, los piratas hubieran publicado un vídeo del emir de Qatar haciendo las declaraciones y lo hubieran distribuido en YouTube y otras redes sociales. ¿Cómo habrían reaccionado los cataríes? ¿Hasta qué punto habrían sido convincentes sus desmentidos si aparentemente fuera su emir el que hubiera hecho las declaraciones? Bienvenidos al mundo del deepfake.

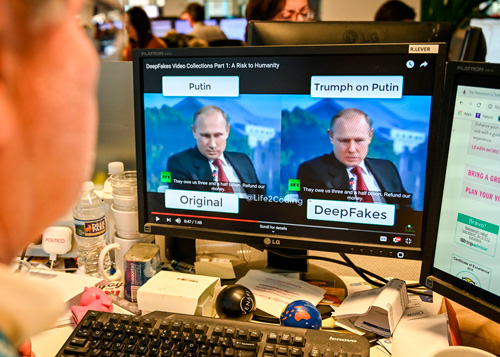

Deepfake (ultrafalso) es el nombre de la tecnología que permite la producción de vídeos convincentes de personas que dicen o hacen cosas que no han dicho ni hecho. Combina técnicas de aprendizaje automático con audio y vídeo para reproducir los gestos y el comportamiento de la víctima mientras un actor lee el guión falso. A través de ese vídeo y audio, los datos llegan a las redes neuronales mediante lo que se denomina aprendizaje profundo, deep learning (de ahí el nombre de deepfake). Cuantos más y mejores datos se proporcionan, más convincente es el falso vídeo o audio.

Hasta hace poco, estas tecnologías se empleaban sobre todo para insertar rostros de actores famosos en otros cuerpos que participaban en vídeos porno. Un uso malintencionado, pero que no ponía en peligro la paz y la estabilidad internacional. Además, la calidad era bastante mala y las falsificaciones eran fáciles de distinguir. Sin embargo, las mejoras en inteligencia artificial, especialmente en las técnicas de aprendizaje automático y profundo (las mismas técnicas que permitieron que el programa Google Alpha Go derrotara al campeón mundial de Go en 2016), han cambiado las reglas del juego.

Buen ejemplo de ello es un vídeo producido el año pasado en el que, el actor Jordan Peele hablaba a través de la boca de Barack Obama. Al principio, se habían limitado a colocar la boca de Jordan Peele en el vídeo del presidente, para decir cosas que él no habría dicho jamás en público. Era un vídeo bastante burdo y fácil de identificar. Sin embargo, bastaron 56 horas de trabajo con técnicas de inteligencia artificial para producir un vídeo capaz de engañar a cualquiera que no estuviera enterado de la falsificación desde el principio. Incluso sabiendo que es falso, no es fácil de diferenciar. Y la tecnología avanza a toda velocidad. Producir este trabajo supuso un gasto considerable de tiempo y tecnología. Pero están desarrollándose aplicaciones que permitirán a cualquiera con un teléfono móvil hacer uno de esos vídeos en cuestión de minutos.

Como demuestra el caso de Qatar, es fácil imaginar hasta qué punto esta tecnología puede llegar a provocar el caos en las relaciones internacionales. Hay una larga historia de utilización de las “noticias falsas” por parte de los Estados para justificar un comportamiento autoritario, desde Bismarck cuando manipuló el telegrama de Ems para hacer que Napoleón III declarase la guerra a Rusia hasta los hombrecillos verdes de 2014 en Crimea. Esa desinformación se convierte en mucho más cuando surge de los labios de dirigentes políticos extranjeros. Cualquier tensión geopolítica podría transformarse rápidamente en un conflicto real. Las zonas de tensiones étnicas o religiosas, como el enfrentamiento entre Armenia y Azerbaiyán por Nagorno Karabaj, pueden ser especialmente vulnerables. Los países no son los únicos capaces de aprovecharse de estas tecnologías. Otros agentes como Daesh podrían utilizar los vídeos ultrafalsos para alimentar el odio religioso e incitar a cometer más atentados y actos violentos. Pensemos en el efecto que tendrían en Oriente Medio unos vídeos en los que líderes occidentales insultaran al profeta o unos soldados quemasen el Corán.

En Occidente estamos cada vez más preocupados por el uso de las redes sociales en las campañas de desinformación para influir y causar fragmentación en los debates políticos de nuestras sociedades. Aumentan las pruebas de que Rusia trató de influir en las elecciones presidenciales de 2016 en Estados Unidos y el referéndum sobre el Brexit. Aunque sigue siendo exagerado decir que los dos resultados fueron consecuencia de las actuaciones rusas, sigue habiendo una gran inquietud sobre nuestra vulnerabilidad ante tales actividades. Existe la percepción de que las operaciones rusas de desinformación forman parte de una estrategia de guerra híbrida para desestabilizar las sociedades occidentales, fragmentar la UE y descomponer la OTAN. Quizá es excesivo hablar de estrategia meditada, pero no cabe duda de que los servicios de inteligencia rusos operan activamente en las redes sociales y el ciberespacio en general. Han comprendido, antes que muchos en Occidente, cómo utilizar los algoritmos que garantizan los ingresos publicitarios de redes sociales como Facebook y Google para asegurarse de que las noticias falsas lleguen siempre a las cajas de resonancia más susceptibles de creerlas. La existencia de los vídeos ultrafalsos forzosamente hace que estas operaciones de desinformación sean más eficaces y más peligrosas para el diálogo político coherente. Es evidente que el despliegue de vídeos así podría provocar el caos en el debate sobre el Brexit (si es que es posible más caos) o las discusiones internas de la UE sobre el futuro de la Unión.

Los riesgos afectan también al mundo empresarial. Las empresas son muy conscientes de la importancia que tiene la Responsabilidad Social Corporativa y de que su éxito a largo plazo depende no solo de su comportamiento económico sino también de su reputación. La mala imagen, ya sea por acusaciones de malos tratos a sus empleados, mala conducta empresarial o daños medioambientales, puede tener efectos negativos entre los clientes y los accionistas. Hay otro fenómeno más reciente, que es hasta qué punto la reputación de una compañía depende, además de su comportamiento global, del comportamiento privado y las convicciones de sus altos directivos. En el Reino Unido hubo un caso reciente en el que un prestigioso acontecimiento cultural canceló el patrocinio que le prestaba una gran empresa por la oposición de uno de sus directivos al matrimonio homosexual. De modo que es innegable el peligro que representan unos vídeos en los que altos ejecutivos parecen expresar dudas sobre el comportamiento económico o corporativo de su empresa, o incluso manifiestan opiniones privadas políticamente inaceptables. Un vídeo ultrafalso en el que dé la impresión de que un alto directivo pone en duda la veracidad de los datos económicos de su empresa, si se distribuye por las redes sociales, podría tener consecuencias devastadoras para el valor de las acciones de la compañía, especialmente en momentos delicados como unas negociaciones de adquisición o fusión empresarial. Para cuando la empresa pudiera aclarar la verdad y convencer a los mercados, el daño ya estaría hecho.

Ante la perspectiva de estas nuevas tecnologías que amenazan con socavar el concepto de verdad todavía más que las redes sociales, muchos depositan su fe en la propia tecnología. Están desarrollándose técnicas de aprendizaje automático capaces de identificar los vídeos ultrafalsos advirtiendo mínimos fallos que un observador humano puede no percibir. Los defensores de este enfoque técnico alegan que permitirá identificar rápidamente los vídeos falsos y anular su efecto. Las empresas propietarias de redes sociales podrán emplear esas tecnologías para resolver el problema sobre la marcha e impedir que este tipo de vídeos se publiquen. Los gobiernos podrán utilizarlas para identificar las falsas declaraciones atribuidas a líderes extranjeros y mitigar sus consecuencias.

Ahora bien, este enfoque tecnológico tiene varios inconvenientes. La tecnología que se utiliza para identificar estos vídeos, el aprendizaje automático, es la misma que se emplea para producirlos. Y, si hay una carrera entre dos tecnologías de aprendizaje automático, la tecnología deepfake siempre irá por delante de la de identificación. Además, está la cuestión de la velocidad. Para mitigar realmente el efecto de estos vídeos, hay que identificarlos y descubrir a sus creadores lo antes posible, pero no está claro que las tecnologías de identificación sean suficientemente rápidas ni capaces de atribuir de forma clara la responsabilidad. En cualquier caso, puede que no importe. Si los vídeos se distribuyen a través de las redes sociales y dependen de sus algoritmos para llegar a las cajas de resonancia más propensas a distribuirlos, calificarlos de falsos no sirve de nada. Hay demasiada gente que siempre va a creer lo que quiere creer, sobre todo en las franjas extremas de la política.

Como ocurre con la mayoría de los problemas en el ciberespacio, la respuesta a los vídeos ultrafalsos debe ser social y política, tanto o más que técnica. En todo lo relacionado con la presencia de noticias falsas en las redes sociales, la capacidad de resistir de la sociedad se construye mediante la educación y el debate crítico. Los vídeos ultrafalsos no van a desaparecer, y vamos a tener que aprender a convivir con ellos y a tratar de mitigar los daños que causan. En el ámbito internacional, eso significa la implicación de los diplomáticos. Estos deben fomentar el diálogo con otros gobiernos —no solo los europeos— para convencerlos de los peligros que representan estos vídeos para todos y la necesidad de instaurar algún tipo de reglas de juego internacionales. Al fin y al cabo, los regímenes autoritarios y personalistas como los de Rusia y China son seguramente todavía más vulnerables que los países occidentales, donde la personalidad de los dirigentes no es un elemento tan crucial para la estabilidad política y social. Como he explicado en otra ocasión a propósito de la diplomacia y el ciberespacio en general, lo importante es identificar intereses comunes desde el punto de vista de la estabilidad internacional y utilizarlos para desarrollar unas normas de comportamiento “aceptables”. Es lo que, en el mundo físico, llevan a cabo los diplomáticos con el derecho internacional desde hace siglos. Quizá en el caso del deepfake también tengamos que conformarnos con “aceptable”.

Traducción de María Luisa Rodríguez Tapia